Zarządzanie danymi SEO w kontekście dużych baz danych to temat, który nabiera coraz większego znaczenia w dzisiejszym cyfrowym świecie. W miarę jak organizacje gromadzą i przetwarzają ogromne ilości danych, pojawiają się unikalne wyzwania SEO związane z dużymi bazami danych, które muszą zostać przez nie rozwiązane, aby osiągnąć sukces. W artykule omówimy:

- Efektywne przetwarzanie dużych baz danych: Jakie technologie mogą pomóc w usprawnieniu tego procesu?

- Zarządzanie bezpieczeństwem danych w dużych bazach: Jakie środki należy wdrożyć, aby zapewnić ochronę informacji?

- Wpływ szybkości ładowania stron z dużymi bazami danych: Dlaczego jest to kluczowy element w strategii SEO?

W każdej z tych sekcji skoncentrujemy się na praktycznych poradach, które umożliwią organizacjom lepsze zarządzanie dużymi zbiorami danych oraz optymalizację stron internetowych pod kątem SEO w celu zwiększenia ich widoczności w wynikach wyszukiwania. Przygotuj się na odkrycie skutecznych strategii, które pozwolą Ci na pełne wykorzystanie potencjału danych w kontekście wyzwań SEO.

Wyzwania w zarządzaniu danymi SEO dla dużych zbiorów danych

Zarządzanie danymi w kontekście SEO w przypadku dużych baz danych stawia przed organizacjami szereg unikalnych wyzwań. W erze Big Data, gdzie informacje napływają z różnych źródeł w zawrotnym tempie, istotne jest skuteczne ich przetwarzanie i wykorzystanie w strategiach SEO. Kluczowe elementy, które należy rozważyć, to:

- Efektywne przetwarzanie dużych zbiorów danych: Proces przetwarzania ogromnych ilości informacji musi być idealnie zsynchronizowany, aby uzyskać pożądane efekty. Według badań IDC, każdego dnia generowanych jest około 2,5 kwintyliona bajtów danych, co wymaga zaawansowanych metod analizy i interpretacji.

- Konieczność inwestycji w zaawansowane technologie: Narzędzia, takie jak Apache Hadoop czy Apache Spark, są niezbędne do efektywnego przetwarzania dużych zbiorów danych. Firmy muszą inwestować w infrastrukturę i specjalistyczną wiedzę, aby móc skutecznie korzystać z tych technologii.

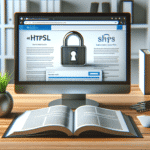

- Bezpieczeństwo danych w dużych bazach: Wdrażanie skutecznych systemów zabezpieczeń, takich jak szyfrowanie i autoryzacja dostępu, jest kluczowe dla ochrony poufności informacji. Według raportu Cybersecurity Ventures, do 2025 roku cyberprzestępczość będzie kosztować świat 10,5 biliona dolarów rocznie.

Zarządzanie danymi wymaga inwestycji w odpowiednie technologie i narzędzia, które umożliwiają efektywne przetwarzanie dużych zbiorów informacji. Mimo że koszty wdrożenia i utrzymania takiej infrastruktury mogą być znaczne, odpowiednie wykorzystanie zasobów przynosi organizacjom oszczędności w dłuższej perspektywie oraz przewagę konkurencyjną.

Również umiejętność interpretacji wyników analiz danych przez pracowników jest niezbędna. Pozwala to na wyciąganie trafnych wniosków i dostosowywanie strategii SEO, co z kolei prowadzi do lepszego pozycjonowania w wynikach wyszukiwania.

Bezpieczeństwo danych jest kolejnym istotnym aspektem, gdyż duże bazy danych niosą ze sobą ryzyko naruszeń, które mogą negatywnie wpłynąć na reputację organizacji. Wdrożenie standardów takich jak RODO (Regulacja o Ochronie Danych Osobowych) jest kluczowe dla zachowania zgodności z przepisami.

| Technologia | Zalety | Wyzwania |

|---|---|---|

| Apache Hadoop | Skalowalność, obsługa ogromnych zbiorów danych, otwarty kod źródłowy | Wysokie koszty wdrożenia, potrzeba specjalistów, złożoność zarządzania |

| Apache Spark | Szybkie przetwarzanie danych w pamięci, wsparcie dla różnych języków programowania | Złożoność konfiguracji, wysoki wymóg zasobów sprzętowych |

| Bazy NoSQL (np. MongoDB, Cassandra) | Elastyczność w zarządzaniu nieustrukturyzowanymi danymi, łatwa skalowalność pozioma | Brak standaryzacji, skomplikowane zapytania, mniejsza dojrzałość w porównaniu z bazami SQL |

Efektywne zarządzanie danymi w kontekście SEO dla dużych baz danych to złożony proces, który wymaga połączenia odpowiednich technologii, umiejętności analitycznych oraz dbałości o bezpieczeństwo informacji. Dzięki temu organizacje mogą poprawić swoją widoczność w wynikach wyszukiwania i osiągnąć lepsze wyniki biznesowe.

Wpływ szybkości ładowania stron na efektywność SEO przy dużych bazach danych

Szybkość ładowania stron internetowych jest fundamentalnym elementem oddziałującym na skuteczność działań związanych z optymalizacją pod kątem wyszukiwarek, zwłaszcza w przypadku dużych baz danych. W erze Big Data, gdzie strony korzystają z ogromnych ilości informacji, optymalizacja czasu ładowania jest kluczowa. Według badań Akamai Technologies, 53% użytkowników mobilnych opuszcza stronę, jeśli ładuje się ona dłużej niż 3 sekundy. Co więcej, Google uwzględnia szybkość strony jako jeden z czynników rankingowych w algorytmach wyszukiwania.

Wyzwania związane z szybkością ładowania stron

- Obciążenie serwerów: Duże bazy danych mogą znacząco obciążać serwery, co wpływa na wydłużenie czasu odpowiedzi.

- Nieskuteczna optymalizacja zapytań: Nieoptymalne zapytania do baz danych mogą powodować opóźnienia.

- Brak cache’owania: Niewdrożenie mechanizmów cache’owania danych zwiększa liczbę żądań do bazy.

Strategie poprawy szybkości ładowania

- Optymalizacja bazy danych: Ulepszanie struktury bazy, indeksowanie oraz optymalizacja zapytań SQL.

- Wykorzystanie CDN (Content Delivery Network): Przyspiesza dostarczanie treści użytkownikom na całym świecie.

- Implementacja cache’owania: Wykorzystanie pamięci podręcznej na poziomie aplikacji i serwera.

- Kompresja plików: Zmniejszenie rozmiaru plików CSS, JavaScript i obrazów.

Korzyści z optymalizacji szybkości

- Zwiększenie satysfakcji użytkowników: Szybko ładujące się strony poprawiają doświadczenie użytkownika.

- Poprawa wskaźników SEO: Lepsza pozycja w wynikach wyszukiwania dzięki krótszemu czasowi ładowania.

- Wzrost konwersji: Szybsze strony zachęcają użytkowników do interakcji i zakupów.

Skupienie się na szybkości ładowania stron w kontekście dużych baz danych jest kluczowe dla efektywności działań SEO. Tylko poprzez zintegrowane podejście do technologii oraz optymalizacji można osiągnąć znaczącą przewagę konkurencyjną na rynku.

Ochrona danych i wyzwania SEO przy dużych bazach danych

W miarę jak organizacje intensywnie wykorzystują analizę dużych zbiorów danych, pojawiają się liczne wyzwania związane z optymalizacją SEO oraz ochroną informacji. Zrozumienie tych trudności jest kluczowe dla skutecznego pozycjonowania w wyszukiwarkach.

Koszty i inwestycje w bezpieczeństwo danych

- Rosnące wydatki: Prognozuje się, że do 2025 roku globalne wydatki na cyberbezpieczeństwo osiągną 1 bilion dolarów.

- Inwestycje w technologie zabezpieczające: Firmy muszą inwestować w systemy antywirusowe, firewalle oraz szkolenia pracowników.

Konsekwencje niewłaściwego zarządzania danymi

- Kary finansowe: Naruszenie przepisów, takich jak RODO, może skutkować grzywnami sięgającymi 20 mln euro lub 4% rocznego obrotu.

- Utrata zaufania klientów: Incydenty bezpieczeństwa mogą prowadzić do spadku lojalności i reputacji marki.

- Negatywny wpływ na SEO: Strony z problemami bezpieczeństwa mogą być penalizowane przez wyszukiwarki.

Wyzwania związane z integracją danych

- Różnorodność źródeł: Dane pochodzą z mediów społecznościowych, CRM, systemów e-commerce.

- Niekompatybilność formatów: Integracja danych w różnych formatach (np. JSON, XML) jest skomplikowana.

- Zarządzanie jakością danych: Konieczność eliminacji duplikatów i błędów.

Rola nowoczesnych technologii w optymalizacji SEO

- Sztuczna inteligencja i uczenie maszynowe: Automatyzują analizę danych i przewidują trendy SEO.

- Narzędzia analityczne: Takie jak Google Analytics 4, oferują zaawansowane funkcje raportowania.

- Zastosowanie blockchain: Wzmacnia bezpieczeństwo i transparentność danych.

Połączenie ochrony danych i wyzwań SEO w kontekście dużych baz danych wymaga innowacyjnych rozwiązań i stałego monitorowania najnowszych trendów technologicznych. Organizacje muszą inwestować w bezpieczeństwo oraz narzędzia analityczne, aby skutecznie konkurować na rynku.

Integracja danych z różnych źródeł a optymalizacja strategii SEO

Integracja danych z wielu źródeł jest kluczowym elementem optymalizacji strategii SEO. Pozwala na uzyskanie pełniejszego obrazu zachowań użytkowników i skuteczniejsze dostosowanie treści do ich potrzeb.

Wyzwania SEO przy integracji danych

- Różnorodność danych: Dane są często przechowywane w różnych formatach i strukturach, co utrudnia ich analizę.

- Silosy danych: Dane rozproszone w różnych systemach mogą prowadzić do niekompletnych wniosków.

- Aktualność informacji: Konieczność ciągłego aktualizowania danych w czasie rzeczywistym.

Techniki i narzędzia integracji

- ETL (Extract, Transform, Load): Proces ekstrakcji, transformacji i ładowania danych do jednolitego systemu.

- API: Wykorzystanie interfejsów programowania aplikacji do komunikacji między systemami.

- Narzędzia integracyjne: Takie jak Talend, Informatica czy Microsoft Power BI.

Korzyści z efektywnej integracji

- Personalizacja treści: Lepsze dopasowanie treści do oczekiwań użytkowników zwiększa zaangażowanie.

- Precyzyjne targetowanie: Możliwość kierowania działań marketingowych do konkretnych segmentów.

- Lepsza analiza konkurencji: Zintegrowane dane umożliwiają monitorowanie działań konkurentów.

- Wzrost ROI: Skuteczniejsze kampanie SEO przekładają się na wyższy zwrot z inwestycji.

Wpływ integracji danych na przyszłość SEO

W dobie rosnącej ilości danych, ich skuteczna integracja i analiza staje się niezbędna. Sztuczna inteligencja i uczenie maszynowe będą odgrywać coraz większą rolę w automatyzacji procesów SEO, umożliwiając bardziej dynamiczne i skuteczne strategie.

Integracja danych z różnych źródeł, ich analiza oraz optymalizacja na podstawie pozyskanych informacji to fundamenty nowoczesnej strategii SEO. Organizacje, które zainwestują w te obszary, zyskają przewagę konkurencyjną i będą w stanie lepiej odpowiadać na potrzeby swoich klientów.

Podsumowanie

Podsumowanie artykułu, który analizuje zarządzanie danymi SEO w kontekście dużych zbiorów danych oraz wyzwania SEO związane z dużymi bazami danych, ujawnia kluczowe informacje, które pomogą Ci w optymalizacji Twoich działań:

- Efektywne przetwarzanie danych SEO: Wykorzystanie nowoczesnych technologii, takich jak Hadoop i Spark, jest niezbędne dla usprawnienia przetwarzania ogromnych baz danych, co pozwala na lepszą optymalizację działań SEO.

- Bezpieczeństwo danych SEO: Inwestycje w systemy zabezpieczeń są kluczowe, aby chronić informacje oraz zachować reputację organizacji w kontekście wyzwań SEO przy dużych bazach danych.

- Szybkość ładowania stron: Kluczowy czynnik w SEO — dane pokazują, że każde opóźnienie w ładowaniu strony powoduje spadek konwersji, co jest istotne przy zarządzaniu dużymi bazami danych.

- Integracja danych SEO: Zbieranie danych z różnych źródeł i ich analiza pozwala na lepsze zrozumienie użytkowników oraz dostosowanie strategii SEO do obszernej bazy danych.

- Wyzwania na rynku SEO: Rosnąca konkurencja sprawia, że każde opóźnienie w ładowaniu strony może prowadzić do utraty klientów, dlatego minimalizacja czasu ładowania jest niezbędna przy dużych zbiorach danych.

Skupiając się na tych kluczowych aspektach, możesz skuteczniej zarządzać danymi SEO oraz poprawić widoczność swojej organizacji w sieci, co przyczyni się do długoterminowego sukcesu w trudnym środowisku SEO związanym z dużymi bazami danych.

Pytania i odpowiedzi

Jakie są podstawowe techniki analizy dużych zbiorów danych w SEO?

Podstawowe techniki analizy dużych zbiorów danych w SEO obejmują eksplorację danych, uczenie maszynowe, analitykę predykcyjną oraz przetwarzanie języka naturalnego (NLP). Każda z tych metod pozwala na wydobycie cennych informacji i wzorców z danych, co wspiera optymalizację pozycjonowania stron internetowych.

Jakie znaczenie ma mobilność w kontekście SEO dla dużych zbiorów danych?

Mobilność odgrywa kluczową rolę w SEO, ponieważ rosnąca liczba użytkowników korzysta z urządzeń mobilnych. Optymalizacja stron internetowych pod kątem urządzeń mobilnych jest niezbędna, aby zapewnić lepsze doświadczenia użytkowników i poprawić wyniki w wyszukiwarkach, co jest istotne w analizie dużych zbiorów danych SEO.

Jakie zagrożenia związane z bezpieczeństwem danych powinny być brane pod uwagę w kontekście SEO?

Zagrożenia związane z bezpieczeństwem danych w SEO mogą obejmować ataki hakerskie, wycieki danych, a także niezgodność z regulacjami prawnymi dotyczącymi ochrony danych. Ważne jest, aby organizacje wdrażały solidne zabezpieczenia oraz regularnie aktualizowały swój system ochrony danych, aby zabezpieczyć działania związane z optymalizacją SEO.

Jakie są najpopularniejsze metody monitorowania wydajności stron internetowych w SEO?

Najpopularniejsze metody monitorowania wydajności stron internetowych w SEO to użycie narzędzi analitycznych, takich jak Google Analytics, Pingdom, GTmetrix oraz Lighthouse. Te narzędzia oferują szczegółowe raporty dotyczące szybkości ładowania, wydajności i użyteczności stron, co jest kluczowe dla skutecznej optymalizacji SEO.

Jak wykorzystać zbiory danych w kampaniach marketingowych SEO?

Firmy mogą wykorzystać zbiory danych w kampaniach marketingowych SEO do segmentacji klientów, personalizacji treści, analizy wyników kampanii oraz przewidywania potrzeb klientów. Dzięki tym informacjom możliwe jest tworzenie bardziej efektywnych strategii marketingowych, które wspierają optymalizację SEO.

Co to jest ETL i jakie ma zastosowanie w zarządzaniu danymi SEO?

ETL oznacza Extract, Transform, Load i jest to proces ekstrakcji danych z różnych źródeł, przekształcania ich w odpowiedni format oraz ładowania do docelowej bazy danych. W kontekście SEO, ETL umożliwia optymalizację analizy danych związanych z pozycjonowaniem, co wspiera skuteczne strategie SEO.

Jakie umiejętności są kluczowe dla specjalistów ds. danych w kontekście SEO?

Kluczowe umiejętności dla specjalistów ds. danych w kontekście SEO obejmują analityczne myślenie, znajomość narzędzi analitycznych SEO, umiejętność programowania (np. Python lub R), a także biegłość w zarządzaniu bazami danych i interpretacji wyników analizy danych SEO.

Jak często należy aktualizować dane w ramach strategii SEO?

Dane w strategii SEO powinny być aktualizowane regularnie, najlepiej co miesiąc lub co kwartał, w zależności od dynamiki branży i działań marketingowych. Regularne aktualizacje pozwalają na szybsze reagowanie na zmiany trendów i potrzeb użytkowników, co jest niezbędne dla utrzymania skutecznej optymalizacji SEO.

O autorze | Specjalista SEO: Mateusz Kozłowski

Mateusz Kozłowski, SEO Freelancer / Specjalista SEO z pasją związany z marketingiem internetowym (w tym z pozycjonowaniem strony) od 2005 roku. Zdobywał doświadczenie, pracując z różnej wielkości klientami, od startupów po duże korporacje. Pozycjonował i pozycjonuje projekty polskie jak i zagraniczne. W 2011 roku założył własną firmę, pomagając firmom zwiększać widoczność w internecie. Pasjonat sztucznej inteligencji (AI), tworzy oprogramowanie wykorzystujące API OpenAI. Na blogu dzieli się wiedzą i praktycznymi poradami z zakresu SEO oraz AI.