Co to jest Googlebot i jaka jest jego rola w pozycjonowaniu stron?

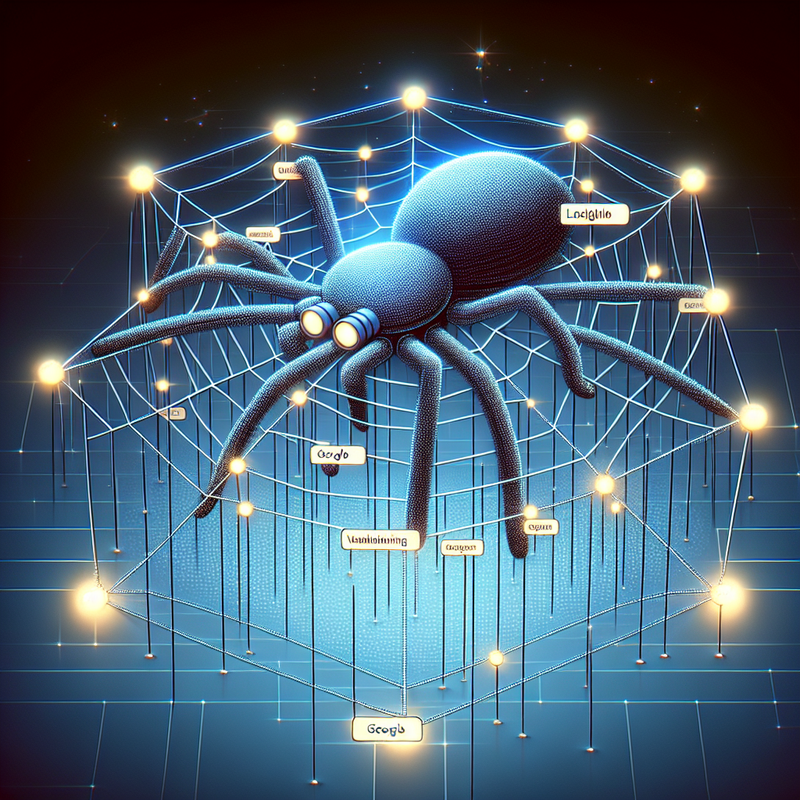

Googlebot to robot internetowy, znany także jako crawler, spider lub bot, który jest odpowiedzialny za skanowanie i indeksowanie stron internetowych dla wyszukiwarki Google. Jego działania mają kluczowy wpływ na pozycjonowanie stron w Google, ponieważ to właśnie Googlebot decyduje, jakie treści zostaną zaindeksowane i tym samym będą mogły pojawić się w wynikach wyszukiwania. Proces indeksowania rozpoczyna się od przeszukania zasobów internetowych poprzez linki URL, co jest znane jako crawling. Googlebot odwiedza strony, zbiera informacje o ich zawartości i przekazuje je do bazy danych Google, gdzie są one przetwarzane i analizowane.

Warto zwrócić uwagę na różne typy Googlebotów, takie jak Googlebot Mobile, Googlebot Image, Googlebot News czy Googlebot Video, każdy przystosowany do specyficznych zadań, co pozwala na jeszcze dokładniejsze i bardziej precyzyjne indeksowanie treści. Dla przykładu, Googlebot Mobile jest przeznaczony do skanowania treści zoptymalizowanych pod kątem urządzeń mobilnych, co jest szczególnie ważne w kontekście aktualizacji algorytmu Mobile First Index.

Jednym z najważniejszych aspektów zarządzania Googlebotem jest odpowiednia konfiguracja pliku robots.txt, który pozwala webmasterom na kontrolowanie dostępu bota do konkretnej treści. Plik robots.txt może zawierać dyrektywy typu Disallow, które informują Googlebota, które strony nie powinny być indeksowane. Ważnym narzędziem wspomagającym ten proces jest również mapa witryny (sitemap.xml), która ułatwia botowi nawigację po stronie i odnajdywanie jej kluczowych elementów.

Indeksowanie może być efektywne tylko wtedy, gdy strona jest odpowiednio zoptymalizowana pod kątem technicznym oraz zawiera wartościowe i unikatowe treści. Elementy takie jak meta tagi, alt tagi, struktura URL, linki wewnętrzne i zewnętrzne, responsywność strony oraz szybkość ładowania (page speed) mają znaczący wpływ na to, jak Googlebot interpretuje i ocenia stronę. Regularny audyt SEO pozwala na monitorowanie tych parametrów i wprowadzanie potrzebnych optymalizacji.

Podsumowując, Googlebot jest kluczowym elementem w procesie pozycjonowania stron w Google. Jego efektywne działanie zależy od technicznej optymalizacji strony, wartościowych treści oraz przestrzegania wytycznych Google dotyczących SEO. Staranna konfiguracja pliku robots.txt, mapy witryny oraz regularne monitorowanie wyników w Google Search Console są fundamentalnymi krokami do osiągnięcia lepszych pozycji w wynikach wyszukiwania.

Jak działa Googlebot i jakie ma znaczenie dla SEO?

Googlebot jest kluczowym elementem w procesie pozycjonowania stron w Google. Jest to robot internetowy, który skanuje strony internetowe w celu dodania ich do indeksu wyszukiwarki. Proces ten, zwany crawlingiem, polega na automatycznym przeszukiwaniu stron przez Googlebota, który śledzi linki prowadzące do różnych URL-i, analizuje treści oraz sprawdza struktury stron internetowych. Wyniki tego procesu mają bezpośredni wpływ na SEO i widoczność witryny w wynikach wyszukiwania.

Jak Googlebot działa?

- Crawling i indeksowanie: Googlebot przeszukuje sieć, skanując miliardy adresów URL, śledząc linki i analizując zawartość stron. Dane te są następnie przechowywane w indeksie Google, który jest bazą danych wszystkich zaindeksowanych stron.

- Algorytmy: Na podstawie zgromadzonych danych Google stosuje zaawansowane algorytmy, takie jak algorytm BERT, aby ocenić wartość i jakość strony. Algorytmy te biorą pod uwagę setki czynników rankingowych, w tym optymalizację treści, szybkość ładowania strony (page speed), responsywność (mobile first index), a także strukturę linków (link building).

- Crawl Budget: Googlebot ma określony crawl budget, czyli limit, ile stron w danej witrynie może przeskanować. Właściciele stron powinni zadbać o to, aby kluczowe strony były łatwo dostępne dla robota i aby zmniejszyć ilość przekierowań (przekierowanie 301) oraz błędów 404, które mogą marnować crawl budget.

- Plik robots.txt: Plik robots.txt może być użyty do zarządzania dostępem Googlebota do różnych części witryny. Można w nim określić, które strony mają być indeksowane, a które pomijane. Niedostosowanie tego pliku może skutkować brakiem indeksacji istotnych stron.

- Mapa witryny (sitemap.xml): Dostarczanie aktualnej mapy witryny w formacie XML pomaga robotom Google w nawigacji po stronie i odnalezieniu wszystkich ważnych treści. Mapa witryny powinna być zgłoszona w Google Search Console.

- Optymalizacja techniczna: Elementy takie jak tagi meta (meta tag), struktura nagłówków, czy protokół HTTPS są ważne dla poprawnego indeksowania przez Googlebota. Stosowanie tagów noindex i rel nofollow pozwala na zarządzanie tym, które strony i linki są indeksowane.

Znaczenie Googlebota dla SEO

| Lepsza widoczność | Indeksowanie przez Googlebota jest niezbędne, aby strona mogła pojawić się w wynikach wyszukiwania Google. Brak indeksacji oznacza, że strona jest niewidoczna dla użytkowników korzystających z wyszukiwarki. |

| Analiza treści | Googlebot ocenia treści na stronie, identyfikując słowa kluczowe i ich kontekst. Dzięki temu można lepiej dostosować treść do zapytań użytkowników, poprawiając pozycje w rankingu. |

| Aktualizacje i zmiany | Regularne odwiedziny Googlebota pozwalają na szybkie zaktualizowanie indeksu o zmiany w treści i strukturze witryny. To kluczowe dla utrzymania aktualnych informacji w wynikach wyszukiwania. |

| Problemy techniczne | Googlebot może wykryć problemy techniczne na stronie, takie jak błędy 404 czy niska prędkość ładowania, które mogą negatywnie wpływać na SEO. Dzięki Google Search Console można regularnie monitorować te kwestie i wprowadzać potrzebne poprawki. |

Googlebot jest zatem nieodłącznym elementem efektywnego pozycjonowania stron w Google. Dobry audyt SEO, optymalizacja techniczna i regularna analiza działań Googlebota mogą znacząco wpływać na widoczność i osiągi strony w wyszukiwarce.

Indeksowanie stron a rola Googlebota w procesie SEO

Indeksowanie stron internetowych przez Google to proces kluczowy dla ich widoczności w wynikach wyszukiwania, a Googlebot odgrywa w tym niezastąpioną rolę. Googlebot to robot Google, który przeszukuje sieć w celu zaktualizowania bazy danych wyszukiwarki, umożliwiając późniejszą ocenę i ranking stron. Jakie działania powinniśmy podjąć, aby efektywnie współpracować z Googlebotem i poprawić pozycjonowanie stron w Google?

1. Skanowanie i indeksowanie:

Googlebot przegląda stronę, śledząc linki pomiędzy różnymi adresami URL. Ważne jest, aby nasze strony były dobrze połączone, co ułatwi robotowi nawigację. Regularne aktualizowanie zawartości oraz dbanie o wewnętrzne linkowanie może znacznie przyspieszyć proces indeksowania.

2. Optymalizacja techniczna:

Umieszczenie pliku robots.txt w katalogu głównym serwera umożliwia zarządzanie dostępem Googlebota do wybranych części witryny. Niektóre strony, jak koszyki zakupowe, formularze logowania czy strona panelu administracyjnego, nie powinny być indeksowane, gdyż nie zawierają treści wartościowych z punktu widzenia użytkownika.

3. Mapy witryny i Google Search Console:

Warto zadbać o mapę witryny sitemap.xml, która zawiera listę wszystkich istotnych URL-i. Jej zgłoszenie w Google Search Console może znacząco usprawnić proces indeksowania. Narzędzie to pozwala również monitorować efektywność crawl budget, czyli zasobu czasu, jaki Googlebot poświęca na przeszukiwanie naszej witryny.

4. Prędkość ładowania strony:

Page speed jest jednym z kluczowych czynników rankingowych. Strony, które ładują się wolno, mogą zniechęcić Googlebota do pełnego ich przeszukania, co negatywnie wpłynie na proces SEO. Aby temu zapobiec, warto zadbać o optymalizację obrazów, redukcję liczby przekierowań oraz minimalizację JavaScript.

5. Indeksowanie mobilne:

Od marca 2021 roku Google wprowadziło zasadę mobile-first index, gdzie priorytetowo traktowane są wersje mobilne stron. Googlebot Mobile odpowiedzialny za przeszukiwanie stron mobilnych ocenia ich responsywność i optymalizację pod kątem urządzeń przenośnych.

6. Obsługa błędów:

Należy regularnie sprawdzać i naprawiać błędy 404 oraz przekierowania 301. Błędy te dezorientują Googlebota i mogą prowadzić do niewłaściwego indeksowania strony, pogarszając jej ranking.

7. Wykorzystanie tagów:

Tagi meta, takie jak noindex i nofollow, pozwalają na precyzyjne zarządzanie procesem indeksowania. Na przykład, aby zablokować indeksowanie tymczasowych stron produktów, możemy użyć tagu <meta name=”robots” content=”noindex”>.

Podsumowując, Googlebot pozycjonowanie stron w Google oraz skanowanie i indeksowanie to procesy, które wymagają odpowiednich przygotowań technicznych i ciągłego monitorowania. Efektywne zarządzanie tymi działaniami pozwala zwiększyć widoczność witryny w wynikach wyszukiwania, co przekłada się na większy ruch oraz potencjalnie wyższe przychody.

Najważniejsze elementy sprawdzane przez Googleboty podczas indeksowania

Podczas procesu indeksowania stron przez Googleboty, kluczowe jest zrozumienie, jakie elementy są analizowane w celu poprawy pozycjonowania stron w Google. Oto najważniejsze elementy, na które roboty Google zwracają uwagę:

- Treść strony: Googlebot przechodzi przez całą zawartość tekstową strony, analizując jej unikalność, długość, jakość oraz zgodność z frazami kluczowymi. Strony bogate w treść, która jest dobrze napisana i wartościowa dla użytkowników, mają większe szanse na wysoką pozycję w wynikach wyszukiwania.

- Struktura URL: Prostota i przejrzystość adresów URL są istotne dla Google. Przyjazne dla użytkowników i robotów URL-e zawierające słowa kluczowe są lepiej oceniane. Unikaj długich, złożonych i nieczytelnych adresów.

-

Meta tagi: Tagi takie jak

<title>oraz<meta description>odgrywają kluczową rolę. Googlebot analizuje te elementy, aby zrozumieć, o czym jest strona oraz jak powinna być wyświetlana w wynikach wyszukiwania. Poprawne i spójne użycie tagów meta wpływa na optymalizację SEO. - Mapa witryny: Plik sitemap.xml pomaga Googlebotowi w efektywnym indeksowaniu wszystkich dostępnych podstron. Aktualizowana mapa witryny umożliwia robotom szybkie odnalezienie nowej zawartości.

- Link building: Googlebot ocenia także jakość i ilość linków prowadzących do oraz z danej strony. Linki zewnętrzne (backlinki) wpływają na autorytet strony, z kolei linki wewnętrzne pomagają w nawigacji po witrynie.

- Optymalizacja mobilna: W ramach Mobile First Index Googlebot analizuje wersję mobilną strony, sprawdzając jej responsywność i przyjazność dla urządzeń mobilnych. Strony zoptymalizowane pod kątem urządzeń mobilnych mają wyższe szanse na lepsze wyniki w wyszukiwarce.

- Page Speed: Szybkość ładowania strony jest kluczowym czynnikiem rankingowym. Googlebot ocenia czas, w jakim strona ładuje się zarówno na komputerach, jak i na urządzeniach mobilnych. Wolno ładujące się strony mogą zostać gorzej ocenione.

- Plik robots.txt: Plik ten instruuje Googlebota, które strony i części witryny mają być indeksowane, a które zablokowane. Poprawne skonfigurowanie pliku robots.txt pomaga w skuteczniejszym zarządzaniu crawl budget.

- Zaawansowane technologie: Googlebot potrafi również przetwarzać treści oparte na JavaScript. Warto więc upewnić się, że strona jest w pełni dostępna i zrozumiała dla robotów, nawet jeśli korzysta z nowoczesnych technologii.

Pamiętać należy, że regularne przeprowadzanie audytów SEO oraz korzystanie z narzędzi takich jak Google Search Console pomagają w identyfikacji i naprawie problemów wpływających na indeksowanie. Dzięki temu możliwe jest utrzymanie strony w optymalnym stanie, co wprost przekłada się na jej widoczność i pozycjonowanie w wyszukiwarce Google.

Wykorzystanie pliku robots.txt do zarządzania działaniami Googlebota

Plik robots.txt odgrywa kluczową rolę w zarządzaniu działaniami Googlebota na Twojej stronie internetowej, co ma bezpośredni wpływ na pozycjonowanie stron w Google. Optymalizacja i odpowiednia konfiguracja tego pliku może znacząco poprawić efektywność indeksowania i SEO, co w rezultacie przekłada się na lepsze wyniki w rankingach wyszukiwania.

1. Kontrola dostępu do stron

- robots.txt umożliwia ograniczenie dostępu Googlebota do określonych części Twojej witryny. Możesz zablokować indeksowanie stron z poufnymi informacjami, takich jak koszyki zakupowe czy paneł administracyjny, co zapobiega niepożądanemu pojawianiu się tych stron w wynikach wyszukiwania.

2. Optymalizacja crawl budget

- Dzięki poprawnej konfiguracji robots.txt możesz efektywnie zarządzać tzw. crawl budget, czyli ilością zasobów, które Googlebot poświęca na przeszukiwanie Twojej strony. Eliminując zbędne podstrony, skupiasz zasoby Googlebota na ważnych dla Twojego serwisu treściach, co zwiększa szanse na lepsze pozycjonowanie stron w Google.

3. Poprawa prędkości strony

- Ograniczenie indeksowania dużych plików graficznych za pomocą Googlebot Image lub elementów wykonanych w JavaScript przyczynia się do zwiększenia wydajności i page speed Twojej witryny, co jest jednym z czynników rankingowych algorytmu Google.

4. Elastyczność i kontrola

- W pliku robots.txt możesz dokładnie zdefiniować, które roboty mają dostęp do wybranych zasobów. Przykładowo, możesz zezwolić na indeksowanie przez Googlebot Mobile, ale zablokować dostęp dla Googlebot Video, jeżeli zawartość wideo nie jest kluczowa dla Twojej strategii SEO.

5. Narzędzie do unikania duplikatów

- Plik robots.txt może również pomóc w uniknięciu problemów z duplikatami treści. Poprzez zastosowanie odpowiednich komend, takich jak Disallow oraz tagów meta noindex dla powtarzających się podstron, możesz zapobiec obniżeniu wartości Twojej witryny w oczach algorytmów Google.

Aby monitorować efektywność konfiguracji robots.txt i kontrolować działania Googlebota, warto także regularnie korzystać z narzędzi dostępnych w Google Search Console. Pozwoli to na bieżąco dostosowywać ustawienia i optymalizować wyniki pozycjonowania stron w Google. Implementacja technicznych zasad zarządzania Googlebotem może być kluczowym elementem skutecznej strategii SEO.

O autorze | Specjalista SEO: Mateusz Kozłowski

Mateusz Kozłowski, SEO Freelancer / Specjalista SEO z pasją związany z marketingiem internetowym (w tym z pozycjonowaniem strony) od 2005 roku. Zdobywał doświadczenie, pracując z różnej wielkości klientami, od startupów po duże korporacje. Pozycjonował i pozycjonuje projekty polskie jak i zagraniczne. W 2011 roku założył własną firmę, pomagając firmom zwiększać widoczność w internecie. Pasjonat sztucznej inteligencji (AI), tworzy oprogramowanie wykorzystujące API OpenAI. Na blogu dzieli się wiedzą i praktycznymi poradami z zakresu SEO oraz AI.